В чем особенность Qwen 2.5 Max

Qwen2.5-Max вышла в канун Китайского Нового года, 29 января. Новинку выпустил техногигант Alibaba, известный большинству как создатель маркетплейса AliExpress. Однако Alibaba — это еще и одна из крупнейших технологических компаний в Китае, которая специализируется на облачных вычислениях и искусственном интеллекте. Qwen как нейросеть была впервые представлена в апреле 2023 года.

Qwen2.5-Max — новейшая модель, которая, судя по результатам тестирования на бенчмарках, превзошла результаты DeepSeek v3. Сразу стоит отметить, что речь идет не о новой DeepSeek-R1 со способностью к рассуждениям (reasoning), а о предыдущей версии, которая появилась в декабре 2024 года. Далее сравним эту модель с другими достойными конкурентами от OpenAI, DeepSeek, Claude и Anthropic.

Обучение языковой модели 2.5 Max

Обучение Qwen2.5-Max происходило по технологии Mixture of Experts (MoE) — «смесь экспертов». Это значит, что в процессе обучения модель была разделена на отдельные мини-модели, так называемых «экспертов», каждая из которых через обучение получила компетенцию в определенной сфере: в программировании, логике, английском языке и других. Была создана отдельная модель «gating», «привратник», задача которой — перенаправлять. Проанализировав входящую задачу, она может сразу прикинуть, который из «экспертов» будет более компетентен в сфере, и к которому из них стоит прислушаться.

Обособленно модели-эксперты работать не могут — они входят в состав большой языковой модели. Когда в нейросеть попадает задача, например: «Напиши код на Python», «привратник» может сразу определить, что решать ее будет на 100% эксперт-программист, на 20% эксперт по английскому языку, на 80% эксперт по логике.

Помимо этого, Qwen2.5-Max была «отшлифована» методикой Supervised Fine-Tuning (SFT), которая позволяет «заточить» нейросеть для решения конкретной задачи, а также обучением с подкреплением на основе отзывов людей.

Архитектуру MoE использует и DeepSeek, в том числе из-за ее дешевизны — для решения задач ей нужно в разы меньше вычислительных мощностей. Этот факт отчасти привел к обвалу акций западных производителей GPU-чипов, который последовал за выходом DeepSeek-R1: именно эти чипы используются для обучения нейросетей. Китайские модели показали, что для создания работающего и весьма качественного продукта необязательно использовать гигантские мощности, а вместе с ними — огромные деньги.

Испытания Qwen 2.5 Max

Самый простой способ определить способности большой языковой модели — провести испытания на бенчмарках. Это своего рода «линейки», которыми можно сравнительно объективно «измерить» нейросети и сравнить их между собой.

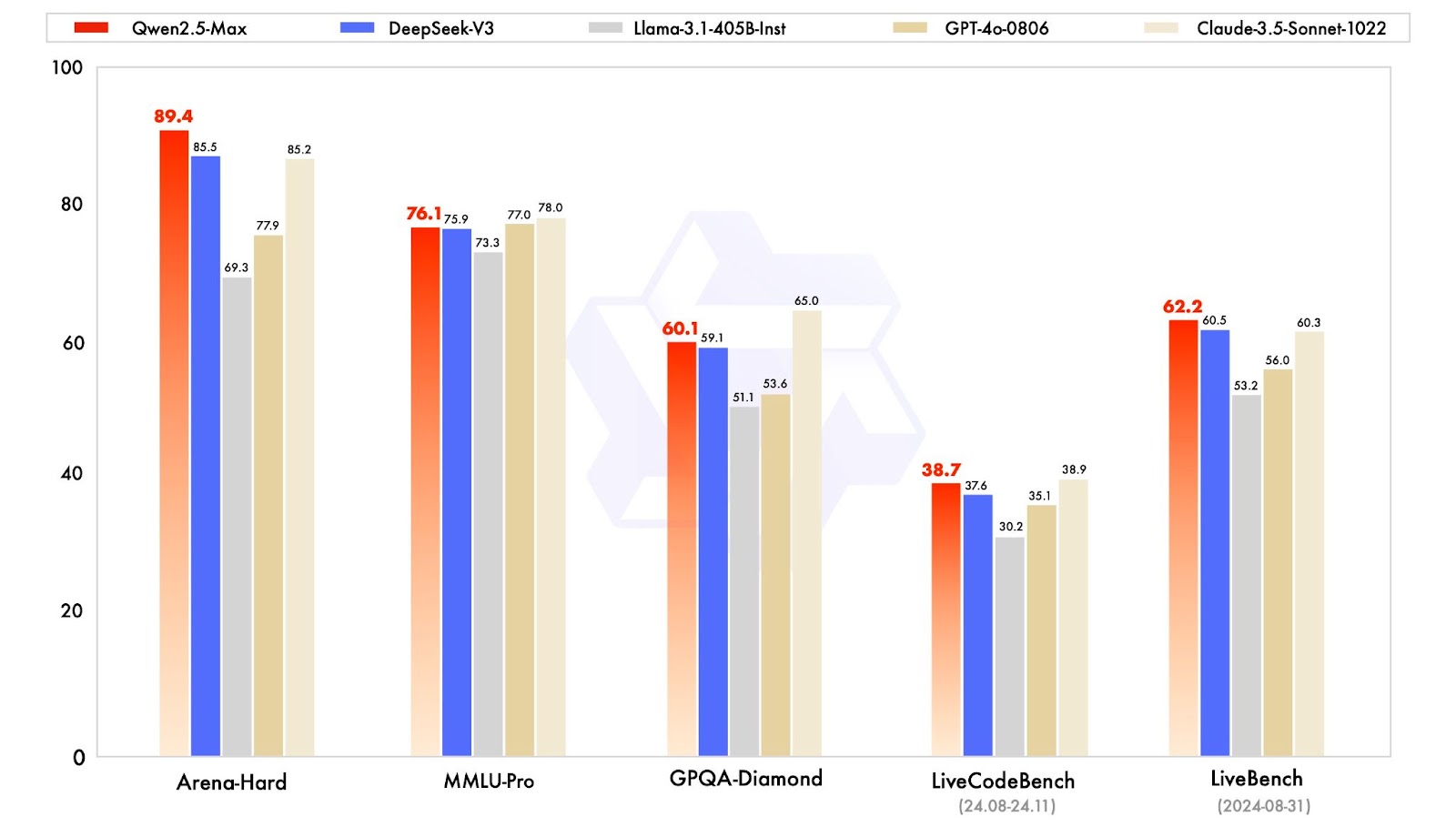

Qwen2.5-Max сравнивали с лидирующими на тот момент нейросетями — такими как DeepSeek V3, GPT-4o и Claude-3.5-Sonnet.

Испытания проходили на разных бенчмарках.

MMLU-Pro проверяет знания модели на университетском уровне: примерно то, что проходят студенты высших учебных заведений. Здесь Qwen2.5-Max набрал 76,1%, уступив GPT-4o с 77,0% и Claude-3.5-Sonnet с 78,0%.

LiveCodeBench — программистский бенчмарк, который, собственно, и проверяет умение нейросети решать связанные с кодингом вопросы. Здесь китайская модель уступила разве что GPT-4o — они набрали 38,7% и 38,9% соответственно.

LiveBench — бенчмарк, который оценивает общие знания нейросети, самые заурядные вопросы. Вот здесь Qwen2.5-Max оказалась звездой — она обогнала всех конкурентов, набрав 62,2%.

GPQA-Diamond — датасет, также проверяющий общие знания, но при этом еще и защищенный от возможности «погуглить». Иными словами, нейросеть не ищет ответы на вопросы в интернете, а отвечает, используя те знания, на которых обучалась. Qwen2.5-Max набрала 60,1%, что мало по сравнению с результатом Claude-3.5-Sonnet в 65,0%, но все равно значительно больше, чем у DeepSeek V3, GPT-4o и Llama-3.1.

Наконец, последний бенчмарк — Arena Hard, разработанный специально для имитации ситуаций, которые происходят в реальной жизни. Он отличается от традиционных бенчмарков, часто представляющих из себя просто набор вопросов, и призван улавливать нюансы. И в нюансах Qwen2.5-Max оказалась лучше аналогов: она получила 89,4%, обогнав остальные модели.

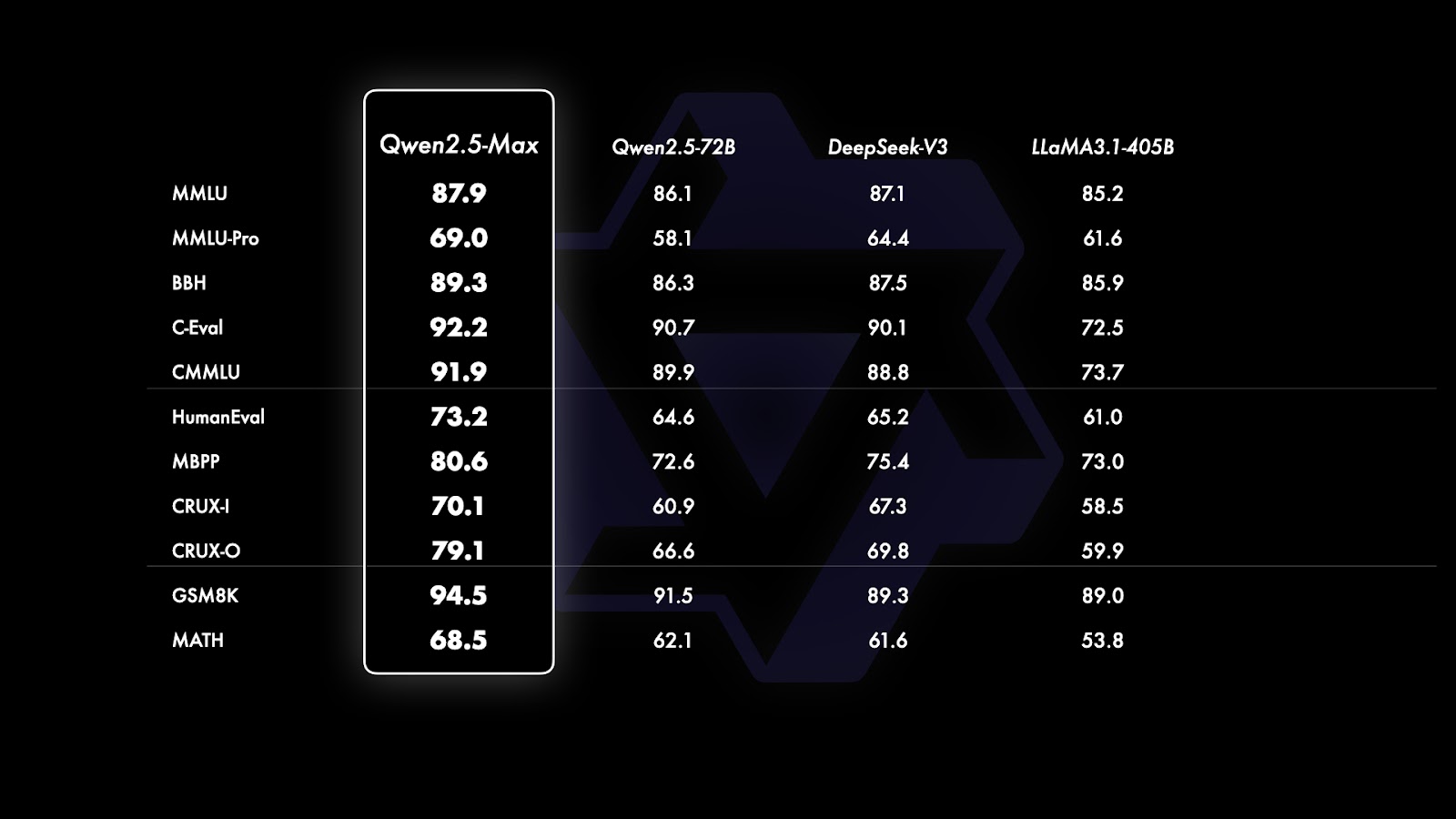

Также разработчики показали испытания базовых моделей, при этом уточнив, что у них не было доступа к моделям от OpenAI и Anthropic. Они «закрытые», в отличие, например, от DeepSeek с открытым исходным кодом.

Qwen 2.5 Max против DeepSeek, Gemini и ChatGPT

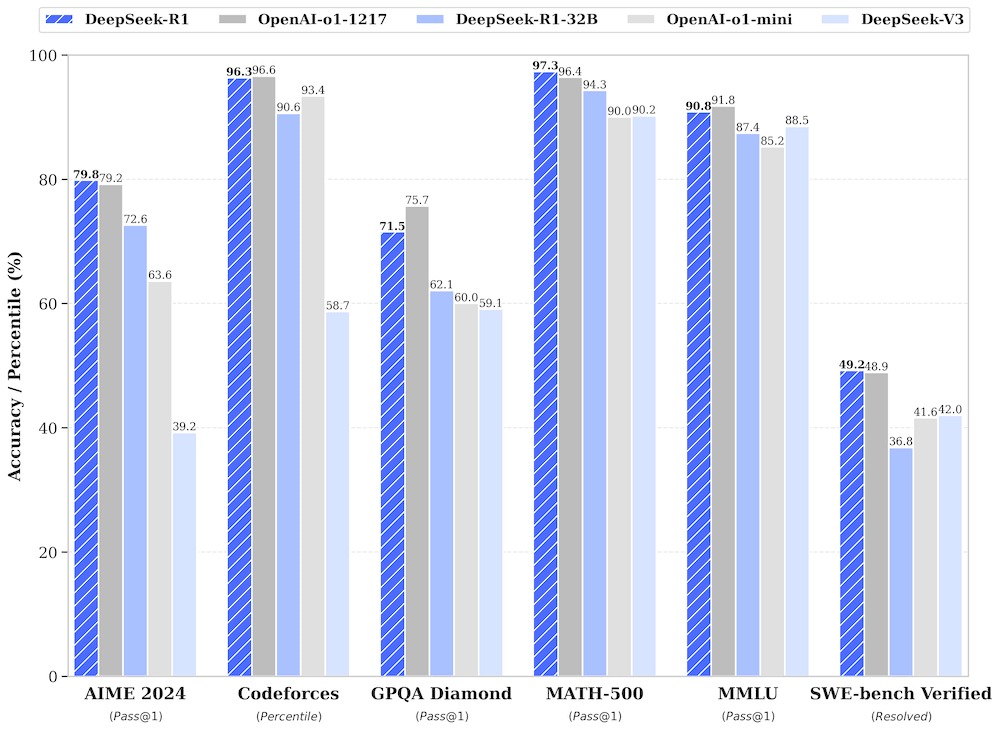

Qwen2.5-Max не сравнивали с новейшими большими языковыми моделями, которые наделали столько шума в цифровом пространстве, а именно с DeepSeek-R1, o3-mini от OpenAI и Gemini 2.0 Flash от Google. Но мы можем прикинуть, насколько нейросеть от Alibaba превосходит их или уступает им, посмотрев на результаты испытаний на бенчмарках.

Результаты DeepSeek-R1:

Дополнительные неофициальные испытания: по ссылке.

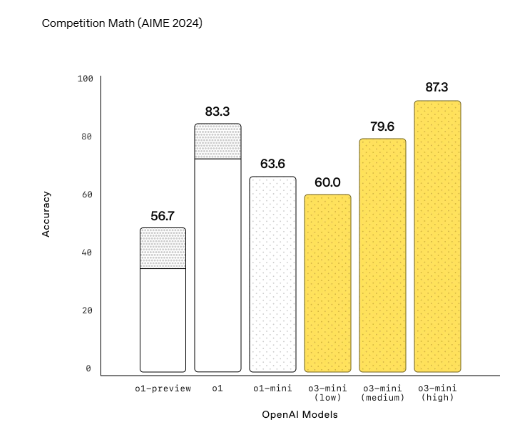

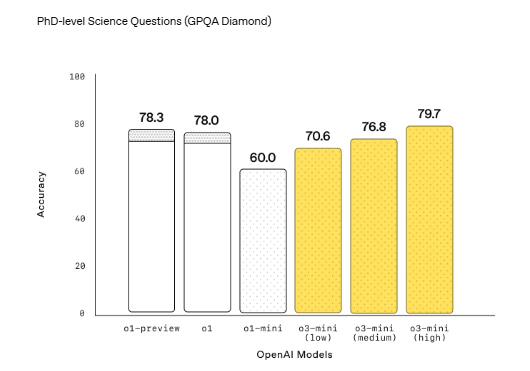

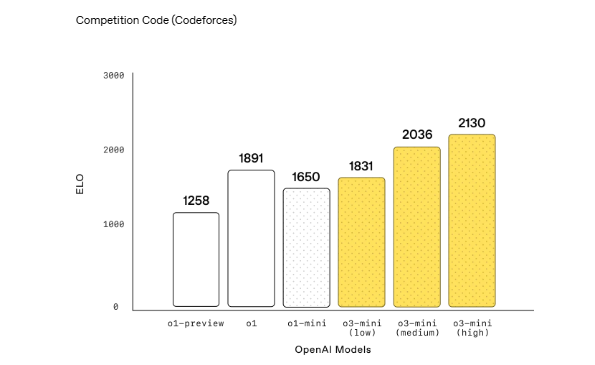

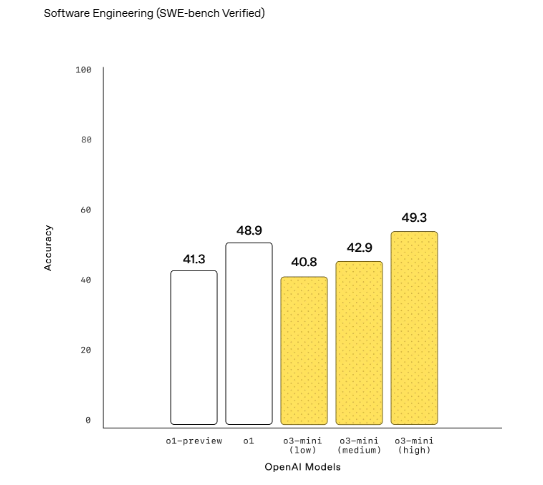

Новинка OpenAI o3-mini не сравнивалась с другими моделями — только со своими же предыдущими версиями, причем тестирования проводились только по бенчмаркам, связанным с программированием, математикой и логическими рассуждениями. Впрочем, информация по другим бенчмаркам тоже имеется, хоть и ориентировочная.

На официальном сайте OpenAI — только данные по кодингу и математике:

Результаты Gemini 2.0 Flash:

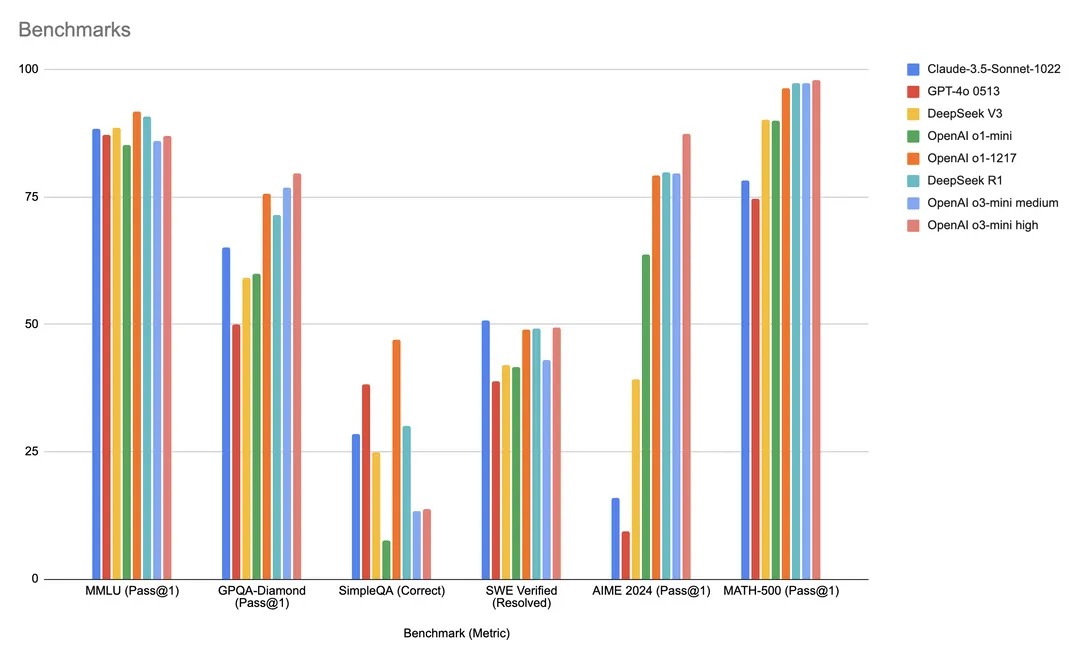

Теперь все эти результаты можно свести в одну таблицу. Они не будут сверхточными — все-таки речь идет не о сопоставлении больших языковых моделей в режиме реального времени, — однако вполне дадут понять, на что способна каждая из них. Сопоставляться будут только релевантные бенчмарки.

У OpenAI o3-mini почти нет официальных результатов испытаний, однако есть любительские.

Здесь видно, что в плане математики и программирования OpenAI o3-mini превосходит остальные бенчмарки, но уступает конкурентам в категории общих знаний. Причем в некоторых категориях значительно лучше показывает себя OpenAI o1 — более ранняя версия нейросети от западного техногиганта.

Qwen2.5-Max действительно показывает неплохие результаты по сравнению с DeepSeek V3, GPT-4o и Claude-3.5-Sonnet, при этом уступая DeepSeek-R1 и OpenAI o3-mini. Из новейших нейросетей она способна конкурировать разве что с Gemini 2.0 Flash от Google, но у Gemini есть свое преимущество, и это — очень широкое окно контекста в миллион токенов. Это значит, что нейросеть способна обработать больший объем информации за один раз.

В отличие от DeepSeek-R1, в модели от Alibaba есть возможность генерации изображений и видео. Она также подгружает десятки источников информации, как и DeepSeek, в отличие от ChatGPT, у которого выдача ограничивается 10–15 медиа.

Однако сила этой нейросети — не в параметрах, которые понимают лишь технические энтузиасты, а в универсальности решения. На фоне релизов конкурирующих нейросетей Qwen 2.5 Max больше напоминает модель «5 в 1». Она для выполнения большинства базовых задач, как генерация текста, анализ несложных документов, создания фото и видео. Эта нейросеть больше напоминает «лучшую версию себя», но на уровне международной ИИ-гонки остается в догоняющих игроках.

Функционально интересной Qwen2.5-Max не назвать, но любопытно в ней другое — то, в какой момент нейросеть была представлена широкой публике. Alibaba показали свою нейросеть во вполне конкретное время: сразу после выхода DeepSeek-R1, появление которой произвело фурор во всем цифровом мире, непосредственно перед Китайским Новым годом. На волне заявлений Банка Китая вложить 1.7 трлн юаней (около 300 млрд долларов), на фоне роста скачиваний приложения своего конкурента DeepSeek — все это напоминает релиз новой модели исключительно под повестку, в рамках которой можно легко и быстро коммуникационно отработать появление нового решения от Alibaba — концерна, инвестирующего в ИИ и технологии будущего.

В такой ИИ-гонке, кажется, может выиграть сильнейший не только по техническим параметрам, но и по доступности использования своих решений. Китайские нейросети DeepSeek, Qwen, Janus работают по всему миру бесплатно и являются хорошей альтернативой ChatGPT. Экономия на подключении китайских нейросетей — минимум 20 долларов в месяц или 240 долларов в год на одного пользователя. И это при том, что доступ есть лишь у одного сотрудника компании, доступ к тарифу Teams обойдется дороже. Учитывая, что каждая компания как в России, так и за ее пределами стремится снизить косты на найм и операционные затраты, китайские нейросети позволяют малому бизнесу закрывать дешевле, проще и быстрее свои задачи. Qwen и DeepSeek — пока самые удачные варианты для таких компаний.

Гонка технологий только начинается и, уверен, будет идти весь 2025 год. В нее вступят не только США и Китай, но и другие государства, заинтересованные в росте технологий и масштабировании решений вне своей страны.

Скопировать ссылку

Скопировать ссылку