Кажется, цифровой рекрутинг наконец стал реальностью. Но вместе с этими возможностями к нам приходит и новая ответственность — этическая, правовая, стратегическая. Потому что алгоритмы тоже могут дискриминировать. И это уже не теория, а зафиксированный факт.

Почему это важно уже сейчас

Интеллектуальные алгоритмы стали массово использоваться в HR из-за своей эффективности: они экономят время, снимают нагрузку с рекрутеров, позволяют масштабировать поиск на десятки тысяч вакансий. По данным Society for Human Resource Management, уже более 64% компаний по всему миру используют ИИ в процессе подбора персонала — от автоматической сортировки резюме до проведения первичных интервью.

Мировой рынок искусственного интеллекта в сфере HR в 2023 году оценивался примерно в 3,25 миллиарда долларов США, и прогнозируется ежегодный рост со среднегодовым темпом 24,8% в период с 2024 по 2030 год. Основным драйвером этого роста становится автоматизация рекрутинговых процессов. Инструменты на базе ИИ оптимизируют поиск кандидатов, анализ резюме и организацию собеседований, значительно сокращая время найма и повышая качество подбора. Этот тренд особенно важен для крупных компаний и отраслей с высокой текучестью кадров.

Но с ростом автоматизации начали всплывать и системные проблемы. Одна из них — то, как ИИ воспринимает и оценивает людей.

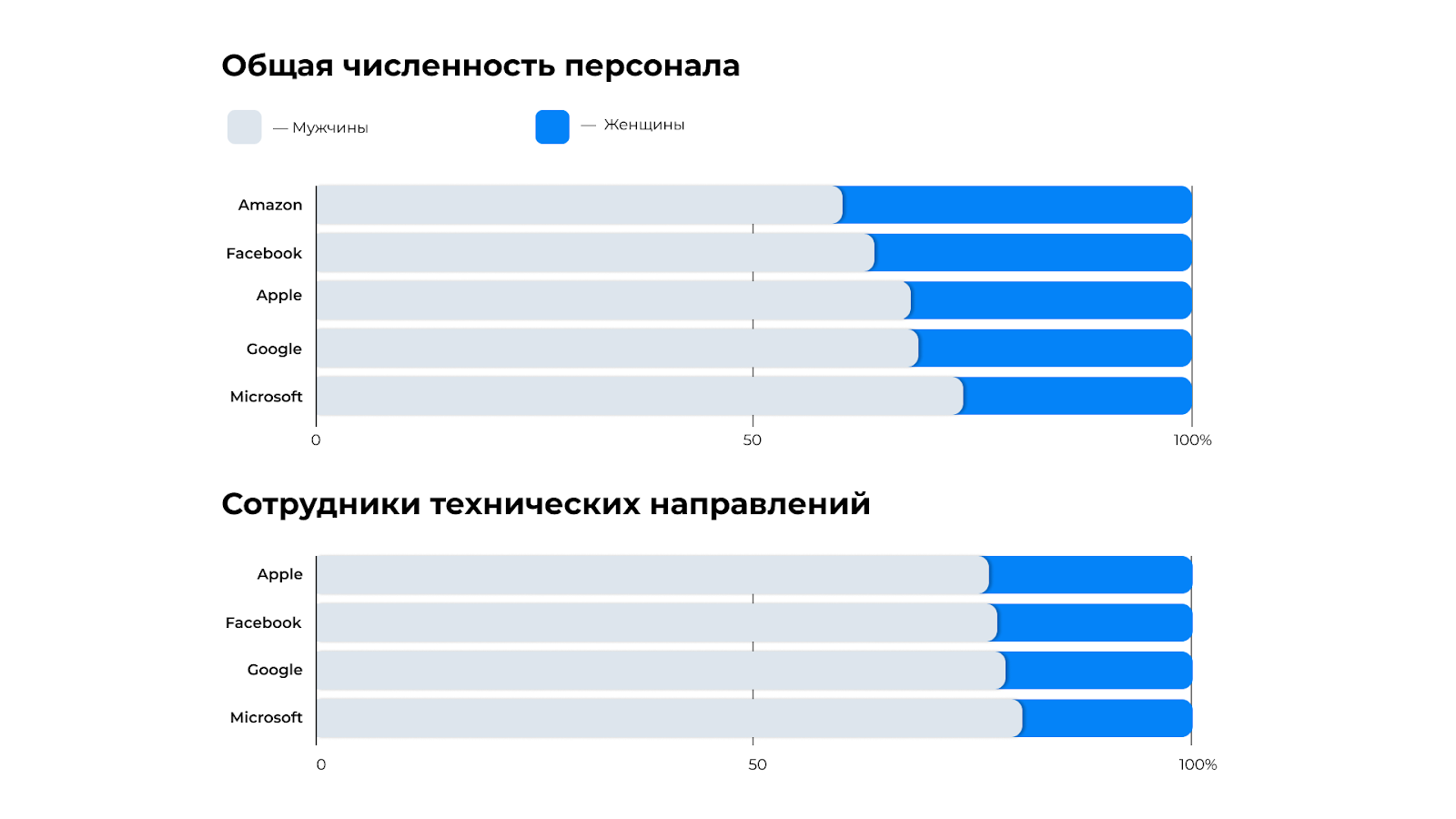

В 2018 году Amazon пришлось отказаться от собственного ИИ для отбора резюме после того, как выяснилось: система занижает рейтинг кандидаток только потому, что большинство топ-резюме в обучающей выборке принадлежали мужчинам. Подобные случаи не единичны. Алгоритмы, обрабатывающие резюме, часто действуют по аналогии с историческими паттернами, закрепляя неэффективные и даже токсичные практики прошлого.

Исследование Университета Вашингтона показало, что ИИ-алгоритмы на базе GPT предпочтительнее выбирают резюме с «белыми» именами и с высокой долей вероятности отклоняют профили темнокожих мужчин.

В России пока рано говорить о масштабной ИИ-дискриминации в подборе персонала — данные по таким случаям единичны, а правовое регулирование только формируется. Однако это не значит, что проблемы нет: как и с любой новой технологией, эффект заметен не сразу. Тем не менее у нас есть важное преимущество — возможность учиться на опыте западных компаний, где случаи дискриминации через ИИ уже стали предметом громких расследований, научных исследований и судебных исков. Сегодня для российских HR-команд и IT-департаментов главное — не повторять этих ошибок, а внедрять ИИ-решения осознанно, с учетом рисков, которые уже проявились за рубежом.

Как ИИ воспроизводит дискриминацию

ИИ не предвзят сам по себе — он лишь отражает то, на чем был обучен. Но если данные содержат исторические перекосы, система начнет их повторять и даже усиливать. Это может быть:

- неполнота и однобокость обучающих данных (например, резюме преимущественно мужчин на топ-позициях);

- непрозрачные критерии подбора (что именно считается «хорошим кандидатом»?);

- отсутствие разнообразия в командах, которые разрабатывают ИИ, — когда никто не замечает, что система несправедливо обходит одних и завышает других.

Результат — потеря талантов, особенно из недостаточно представленных групп. И, конечно, правовые риски.

Как проектировать ИИ-подбор без предвзятости

Автоматизация рекрутинга с помощью ИИ позволяет ускорить найм, расширить воронку и снизить нагрузку на HR-команды. Однако при масштабировании возникает риск: алгоритмы могут неосознанно унаследовать или даже усилить дискриминационные паттерны, если не задать им корректную архитектуру с самого начала. В этом контексте особенно важно, как именно устроен ИИ на уровне данных, логики и контроля.

Обучающие выборки: не повторять ошибки прошлого

Один из главных источников предвзятости — данные, на которых обучается модель. Если алгоритм учится на реальной истории наймов компании, он может зафиксировать и реплицировать системные перекосы: например, недооценку кандидатов определенного возраста, гендера или географии. Чтобы этого избежать, передовые команды применяют комбинированные подходы — от искусственно сгенерированных резюме до анонимизированных, сбалансированных выборок. Это позволяет создать нейтральную отправную точку, не зависящую от прошлых искажений.

Исключение чувствительных параметров

Современные рекрутинговые ИИ могут работать без анализа таких характеристик, как имя, возраст, пол или фотография. Оценка строится на опыте, компетенциях, карьерной логике и содержании ответов. Например, вместо поверхностной классификации резюме система может анализировать конкретные достижения, соответствие требованиям роли и наличие релевантных навыков.

Лингвистическая адаптация: не наказывать за стиль

Лексика — важный аспект в оценке резюме и откликов. Исследования, такие как Harvard Business Review, показывают, что женщины чаще используют слова ухода («помогала», «поддерживала»), а мужчины — достижения («улучшил», «оптимизировал»). Без специальной настройки алгоритм может неосознанно «занижать» вес более мягких формулировок. Чтобы этого избежать, в системе важно учитывать контекст, а не только выбор слов.

Верификация и аудит решений

Ни одна модель не должна оставаться без контроля. Практика ручной проверки шорт-листов, сигналов оспоримых кейсов и регулярного аудита — обязательный элемент для этичного ИИ в HR. Это помогает выявлять системные сбои, уточнять логику модели и не допускать автоматического принятия решений без участия человека.

Как избежать дискриминации: 5 практических шагов

На базе нашего опыта и анализа рынка мы сформулировали базовые принципы, которые помогут другим компаниям перейти на этичный ИИ в рекрутинге:

- Проводите аудит моделей. Минимум раз в квартал проверяйте, кого реально отбирает система, и есть ли перекосы по демографии.

- Удаляйте персонализирующие признаки. Пол, возраст, имя, фото — это данные, которые ИИ должен не учитывать.

- Обучайте команды работе с ИИ. Рекрутеры должны понимать, что алгоритм — это инструмент, а не судья. Не допускайте «автоматической веры» в любую выдачу.

- Используйте инклюзивные критерии подбора. Проверяйте, не занижают ли ваши фильтры шансы кандидатов с нетипичным бэкграундом.

- Следите за прозрачностью вендоров. Если вы покупаете готовое решение — задавайте неудобные вопросы. На чем обучена модель? Кто проверял данные? Как вы отслеживаете дискриминацию?

Заключение

Безусловно, искусственный интеллект сам по себе не обладает мотивацией или предвзятостью — он не «хочет» дискриминировать. Однако именно мы, люди, закладываем в него правила и данные, которые определяют его поведение. Если этический подход не станет фундаментом при разработке и внедрении ИИ, результаты могут не только воспроизводить, но и усиливать существующие предубеждения. Поэтому мой главный призыв к коллегам — HR-директорам и техническим лидерам: не перекладывайте ответственность за этичность на алгоритмы и модели. Вы — те, кто проектирует и контролирует эти системы. От вашего внимания и осознанности зависит, превратится ли ИИ в мощный инструмент равных возможностей или в непреднамеренный источник дискриминации.

Скопировать ссылку

Скопировать ссылку