Прорывная модель

DeepSeek-R1 — разработанная китайскими инженерами большая языковая модель, способная к логическому рассуждению или reasoning, если говорить техническим языком. Она не просто генерирует готовый результат в ответ на запрос, но и подробно расписывает ход своих мыслей.

Прорывной DeepSeek-R1 назвали по разным причинам.

Во-первых, разработчики сразу сделали ее open-source, с открытым исходным кодом. Для поклонников нейросетей это уникальный шанс изучить, как именно обучалась модель, как ее создателям удалось добиться настолько высоких результатов. Для бизнеса это возможность использовать ее мощности для решения своих задач — создания инструментов, которые помогут заработать. На основе такой модели компании могут создавать свои чат-боты и ИИ-ассистенты под конкретную цель.

Открытый исходный код несет и научную пользу. Проекты такого рода не только создают здоровую конкуренцию в сфере ИИ, о чем будет сказано ниже, но и усиливают положение науки, стимулируют технические инновации.

Сами инженеры пишут на своей странице GitHub — ключевом ресурсе для программистов, что открыли исходный код модели для «поддержки исследовательского сообщества».

Во-вторых, DeepSeek-R1 была натренирована обучением с подкреплением (RL), оно же метод проб и ошибок. Похожим способом мы обучаем детей: ребенок взаимодействует с миром, совершает действие, и если оно верное, получает вознаграждение, так что со временем это закрепляет результат. Аналогичный принцип использован и в DeepSeek-R1.

Специально для своей новинки инженеры придумали модель обучения Group Relative Policy Optimization (GRPO), благодаря которой сумели отказаться от модели-критика для оценки действий обучаемой нейросети. Это кратно снизило издержки на тренировку языковой модели, удешевило ее в производстве и ускорило выпуск в период Китайского Нового года, создав громкий прецедент — обвал фондового рынка США буквально за пару дней.

И в-третьих, весьма впечатляющими оказались испытания модели на бенчмарках — традиционном способе проверки производительности нейросетей.

Сильный конкурент

Вычислительные мощности больших языковых моделей проверяются на бенчмарках — это специальные тестовые задания на разные темы. Они могут быть общими, например, из категории школьных знаний, и могут быть специализированными — такие «гоняют» нейросеть по математике университетского уровня или по программированию. Проверка на бенчмарках — единственный способ более-менее объективно сравнить несколько нейросетей между собой, а также выяснить, в чем они сильны, а в чем слабы.

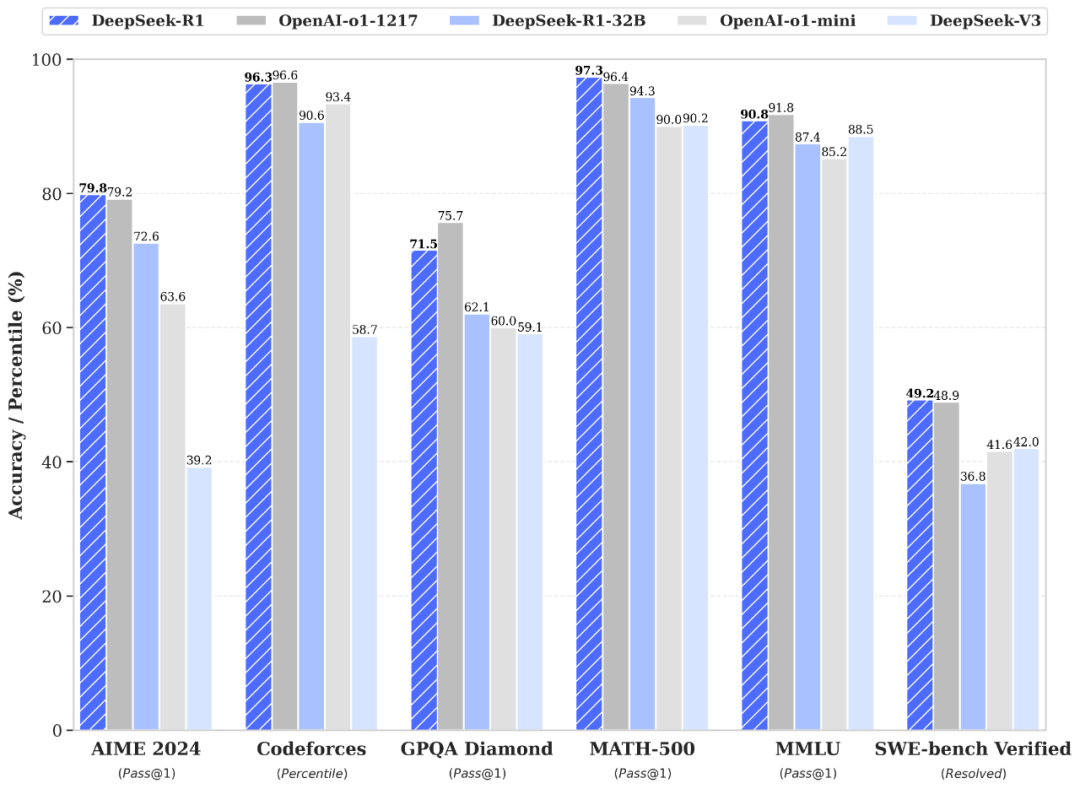

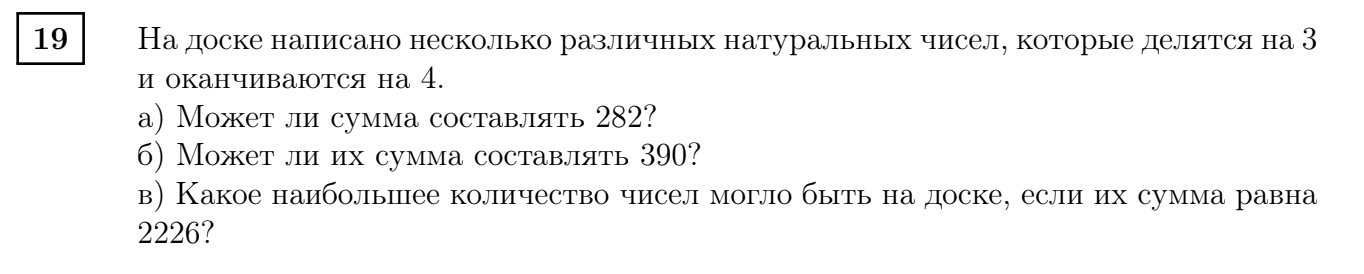

Так выглядит результат сравнения DeepSeek-R1 и новейшей версии нейросети от OpenAI o1:

На этом изображении — шесть бенчмарков, с помощью которых инженеры проверяли способности DeepSeek-R1 и сопоставляли их с возможностями конкурентов, в том числе модели o1 от OpenAI.

AIME 2024 и MATH-500 разработаны для оценки математических способностей языковых моделей: первая оценивает математические рассуждения, вторая — общие школьные знания математики. Как показали испытания, в математике DeepSeek-R1 действительно очень хорош. На AIME 2024 нейросеть набрала 79,8%, обойдя на 0,6 пункта своего главного конкурента — OpenAI o1-1217. Результаты на MATH-500 были еще более впечатляющими: 97,3% против 96,4% у OpenAI o1.

Codeforces и SWE-bench Verified — это бенчмарки программистские, где первый оценивает способности языковой модели к кодингу и алгоритмическим рассуждениям, причем в сравнении с людьми. Здесь DeepSeek-R1 набрала 96,3%, тогда как OpenAI o1 — 96,6%. Второй бенчмарк оценивает способность модели к рассуждениям в отношении повседневных программистских задач. Результаты у обеих моделей невысоки, но DeepSeek-R1 со своим показателем в 49,2% все равно немного превосходит конкурента с 48,9%.

GPQA Diamond и MMLU — бенчмарки категории общих знаний. Первый оценивает способность нейросети отвечать на вопросы уровня «почему трава зеленая», и здесь DeepSeek-R1 набрала 71,5%, тогда как OpenAI o1-1217 — 75,7%. Второй бенчмарк «гоняет» модели по разным областям знаний и оценивает понимание языков, и вот тут китайская модель опередила западную: 91,8% против 90,8%.

Что можно сказать? DeepSeek-R1 — однозначно сильный конкурент OpenAI o1, особенно в категориях программирования, математики и логических рассуждений. Что самое приятное — весь процесс рассуждений у DeepSeek-R1 как на ладони. Китайские инженеры ничего особо не скрывают: ни исходный код, ни то, как нейросеть «думает».

Нейрогонка больших языковых моделей

Выход DeepSeek-R1 стал неожиданностью для всех и моментально привел к цепочке интересных событий.

В первую очередь, обвалились акции производителей GPU-чипов для обучения ИИ, таких как NVIDIA. Для понимания: чтобы обучить предшествующую модель DeepSeek-V3 компании потребовалось около 6 млн долларов, американской Claude 3.5 — десятки или даже сотни миллионов долларов, на GPT-4o и того больше. Большинство нейросетей используют чипы NVIDIA и Anthropic. Думаю, теперь становится понятно, почему Трамп выделяет беспрецедентную сумму на развитие ИИ в США.

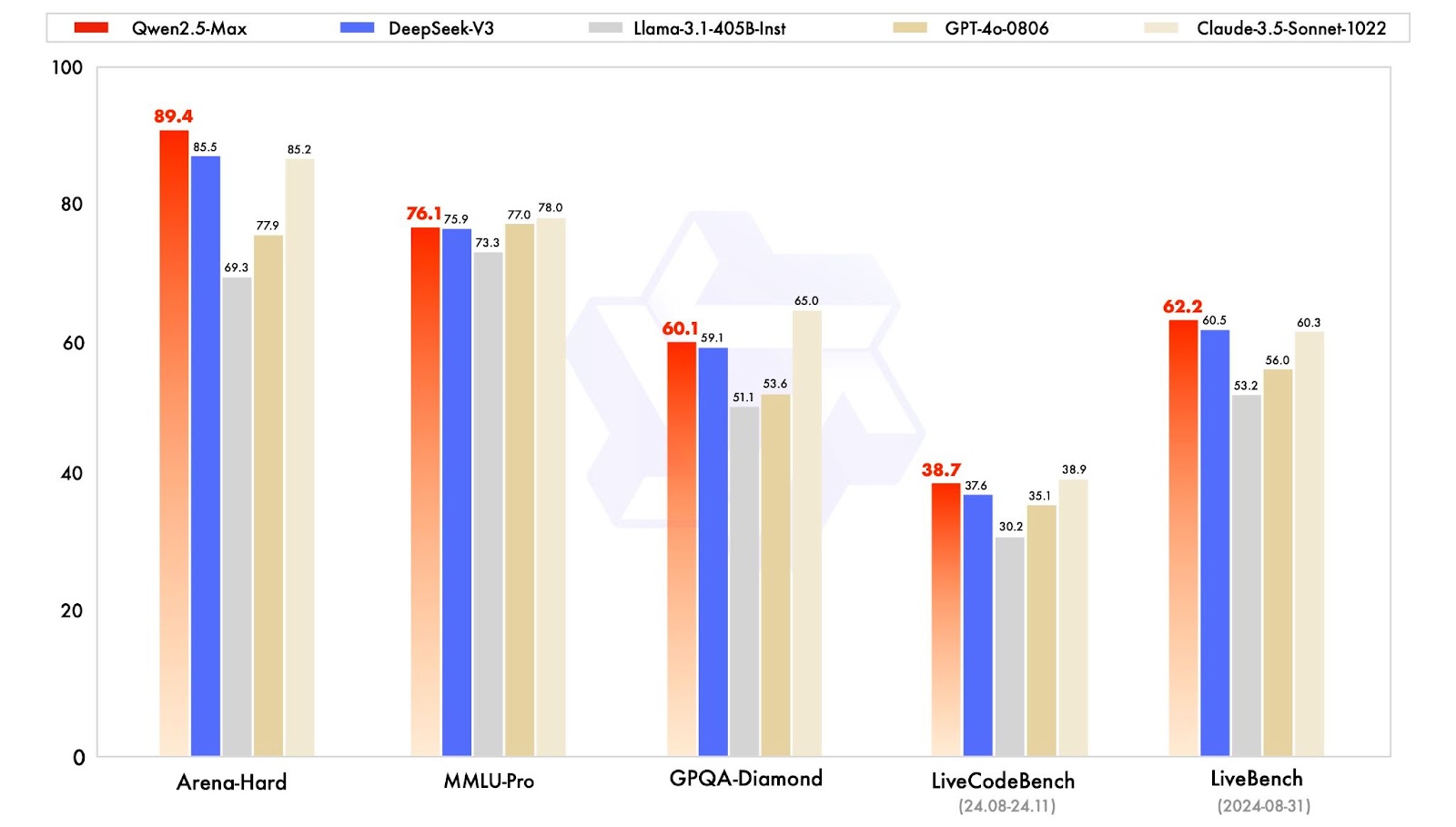

Буквально за сутки приложение DeepSeek вошло в топ по скачиванию в App Store и Google Play, снизило капитализацию производителей чипов в среднем на 10–16%. И, как мне кажется, заставило инженеров Alibaba быстрее представить миру свою альтернативу — новую модель Qwen 2.5 Max.

По результатам тестирования на бенчмарках в сравнении с аналогами модель Qwen 2.5 Max хороша. Но среди тестируемых конкурентов не оказалось ни DeepSeek-R1, ни o1 от OpenAI, то есть на момент релиза самых продвинутых языковых моделей. После такого мощного релиза DeepSeek следить за последователями уже не так интересно: Qwen 2.5 Max не обладает функцией рассуждения, что уже в среде нейроэкспертов воспринимается предвзято — ведь невозможно посмотреть, какие ассоциации, сравнения и выводы делались перед выдачей готового структурированного ответа.

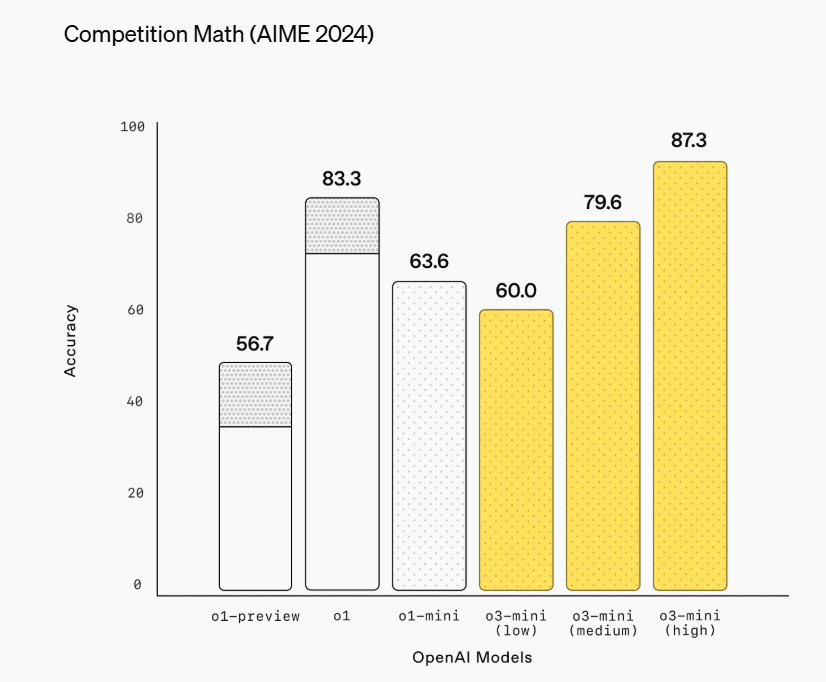

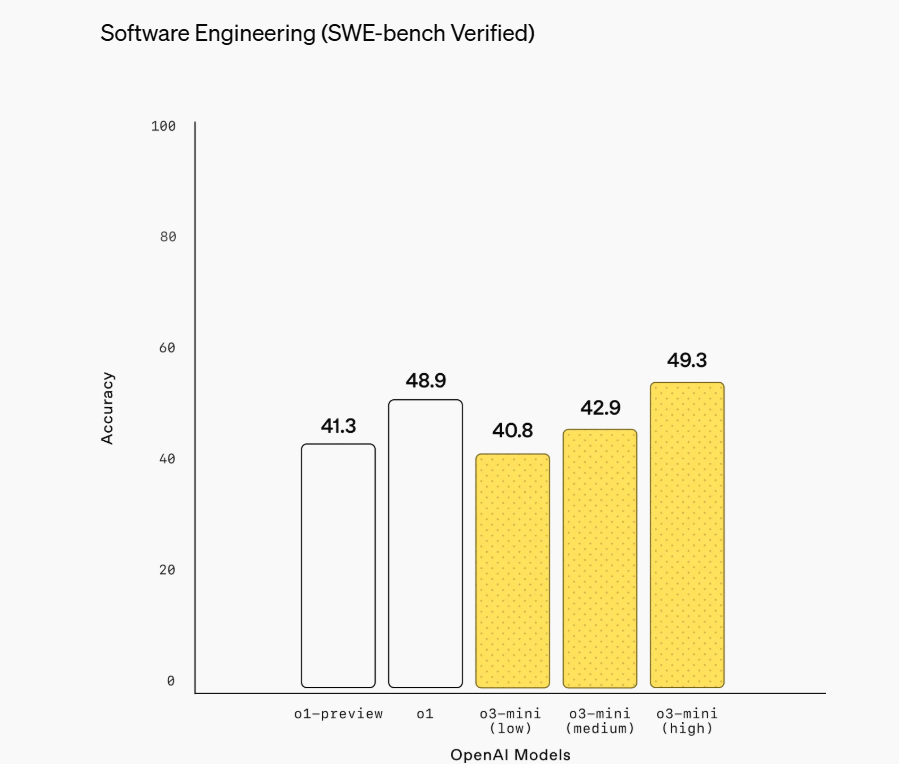

Наконец, 31 января OpenAI ответил конкурентам и представил еще одну модель, тоже с reasoning-функцией — o3-mini. Она так же хорошо и быстро решает задачи, пишет программный код и отображает рассуждения.

То есть буквально за несколько дней января мы оказались наблюдателями не только конкурентной ИИ-гонки, но и зарождения нового «золотого стандарта» в генеративных нейросетях — концепта визуально рассуждающего искусственного интеллекта, максимально повторяющего мыслительный процесс человека. В ходе использования таких технологий становится понятно, как и почему нейросети выдают тот запрос, который выдают. Reasoning позволяет сократить число итераций в нейросети и создавать более четкий промпт с первого раза.

На AIME 2024, бенчмарке оценки математических способностей, DeepSeek-R1 набрала 79,8%, новая модель OpenAI — 87,3%. На SWE-bench Verified — показателе возможностей в программировании — DeepSeek-R1 набрала 49,2%, новинка от OpenAI — 49,3%.

Замечу, OpenAI сосредоточились в демонстрации именно математических способностей и аспектах кодинга — тех областях, в которых DeepSeek-R1 уверенно обогнала o1. Именно в технических показателях происходит ключевая ИИ-гонка нейросетей, метриках, важных для ML-инженеров и разработчиков программных продуктов.

Большинство обывателей, которые уже привыкли к интерфейсу ChatGPT, в DeepSeek распознают знакомые дизайн-элементы: такое же расположение диалогового окна, функций поиска и истории запросов. Однако, сравнивая их, важно учитывать одну вещь.

ChatGPT — это полноценная экосистема, в которую входят генерация изображений, создание отдельных агентов GPTs, обученных на выполнение конкретной задачи, возможность запуска кода внутри чата. Здесь сосуществуют несколько функций, которые миллионы пользователей нейросетей уже «распробовали» и стали воспринимать как должное.

Пока не все фичи от ChatGPT есть в DeepSeek, но я не исключаю, что в ближайшие месяцы все может поменяться. Как поменялось и конкурентное поле в нейросетевом мире. Главное, чем DeepSeek важен для российских бизнесов — это бесплатное подключение без «плясок с бубном» и возможность интеграции своих решений с открытым кодом.

Если смотреть на результаты испытаний на бенчмарках, DeepSeek-R1, несомненно, кое в чем быстрее: например, в разы оперативнее решает математические задачи.

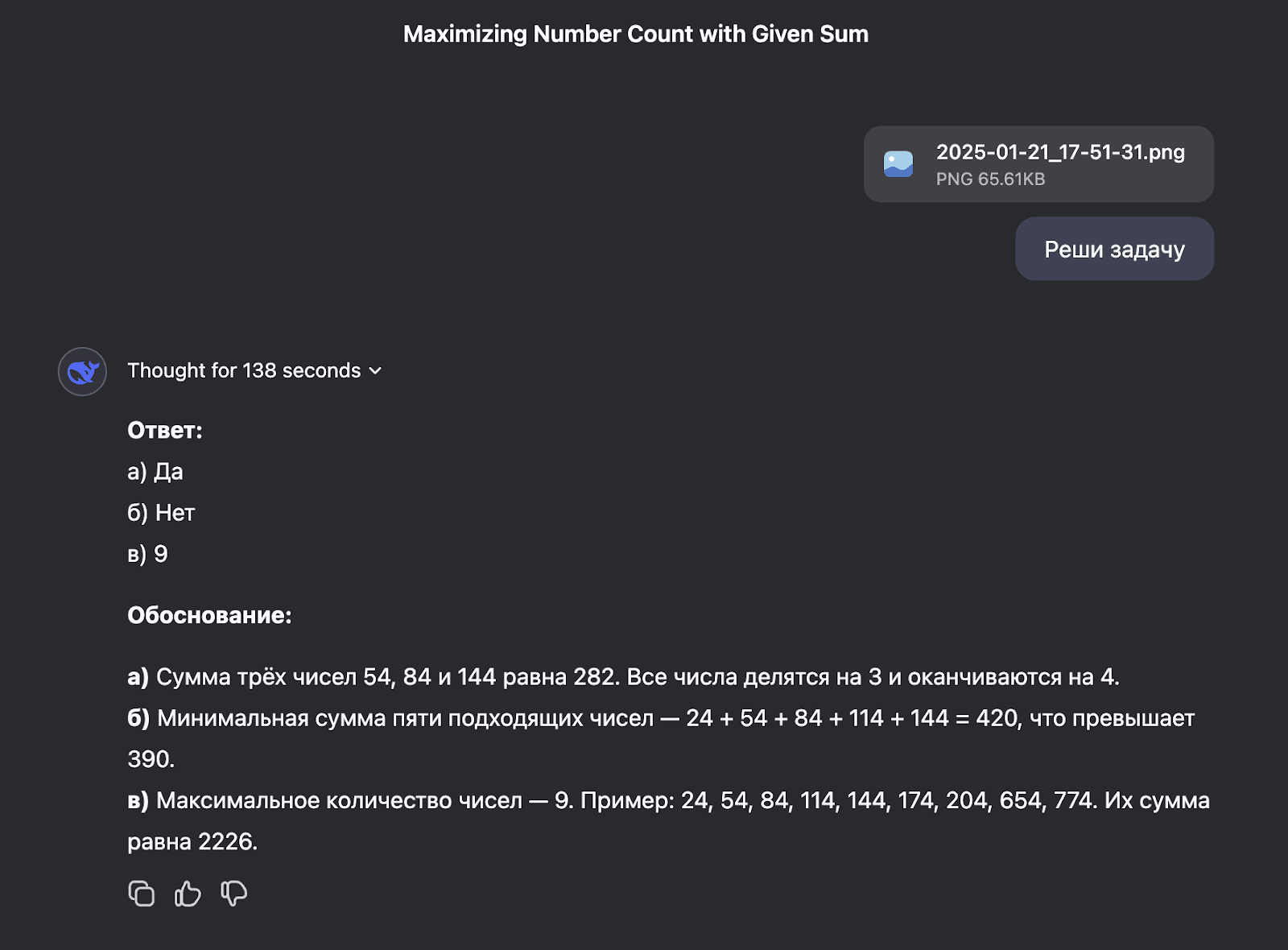

Вот небольшое доказательство — я решил «прогнать» новинку по математике, выбрав для этого задачу из ЕГЭ.

Решение DeepSeek-R1 подготовила за 138 секунд, причем под «спойлером» на скриншоте спрятаны пространные рассуждения.

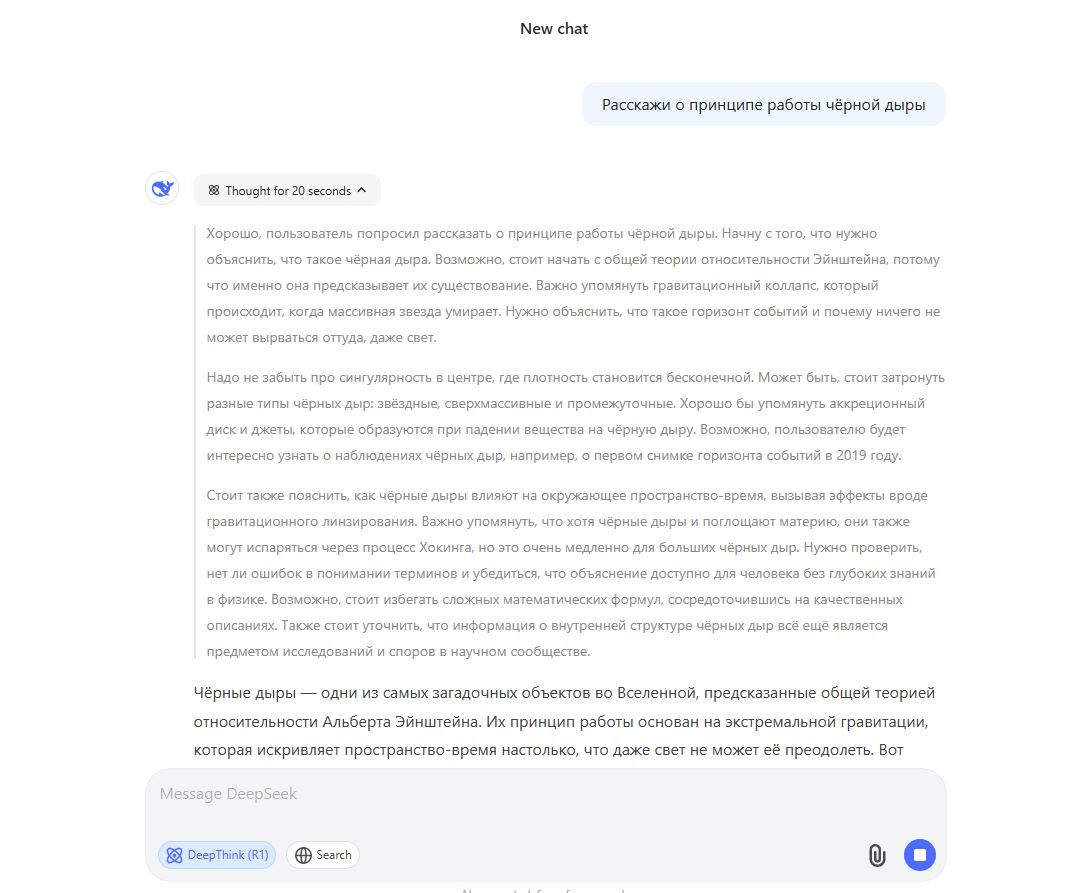

Ту же задачку OpenAI o1 решила за 8 минут 22 секунды. Впечатляющий разрыв.

Как использовать DeepSeek-R1

Познакомиться с DeepSeek можно в чат-боте, который совершенно бесплатен и доступен из России без всяких сторонних инструментов.

По умолчанию он использует старую модель DeepSeek-V3 — можно сравнить ее с GPT-4о в чат-боте ChatGPT. Чтобы воспользоваться новейшей версией с рассуждениями, нужно нажать в левом нижнем углу DeepThink (R1). Это режим более глубокой проработки, который хорошо подходит для разного рода нетривиальных вопросов. Именно он включает режим рассуждений, с которым нейросеть будет демонстрировать каждый этап своей работы.

Вторая кнопка рядом с Deep Think (R1) — это Search, или поиск. Она включает поиск по сети. Что интересно: если спросить у модели, что такое DeepSeek-R1, она не сможет дать ответ, потому что в материалах, на которых она обучалась, еще не было информации о ней самой. Но если включить поиск, то быстро все найдет.

Нейросеть извлекает текст из изображений, как сделала со скриншотом из сборника задач по ЕГЭ. Она «читает» документы, умеет их анализировать и генерировать текст на их основе.

Что ждет дальше

Как вы уже видите, переполох с китайскими нейросетями произошел неспроста. Все произошло не за месяцы или дни, а за считанные часы!

Развитие ИИ-технологий принимает не просто макроэкономический характер, но и становится полем для манипуляции в политике. На фоне серьезных инвестиций Трампа — 500 млрд долларов — Банк Китая выделяет триллион юаней на поддержку своих решений. Другие напряженно следят за тем, как будут разворачиваться технологии в их странах. Россия — не исключение.

Мы начинаем наблюдать не просто ИИ-гонку, но и зарождение серьезной здоровой конкуренции в мировом масштабе. Полагаю, что российские компании в скором времени смогут применить китайские наработки в своих нейросетях. Это был бы логичный шаг к расширению конкурентного поля и поддержке российской ИИ-отрасли.

Согласно федеральному бюджету на 2025 год, на реализацию проекта «Искусственный интеллект», который является частью национального проекта «Экономика данных и цифровая трансформация государства», выделяется 7,7 млрд рублей. Хочется верить, что такое финансирование позволит привести и отечественных ИИ-разработчиков к новым прорывным технологиям, проникновению языковых моделей на уровень человека, ощущающего потребность использования нейросетей вне рамок привычных стандартов и подходов как в работе, так и жизни.

Скопировать ссылку

Скопировать ссылку